Un fichier robots.txt est un petit fichier avec l'extention .txt qui indique aux robots d'exploration des moteurs de recherche de ne pas explorer certaines parties de votre site.

Le fichier robots.txt doit être situé à la racine du site Web (À côté de la page index du site).

Les robots explorateurs de Google (Googlebots) ainsi que les autres robots d'exploration sérieux respectent les instructions des fichiers robots.txt. Cependant, il est possible que d'autres robots ne le fassent pas.

Si vous voulez cacher des informations en empêchant leur récupération par les robots d'exploration, nous vous conseillons d'utiliser d'autres méthodes de blocage, comme la protection par mot de passe par .htacces et .htpasswd.

Un fichier robots.txt ne comprend que trois types d'instruction :

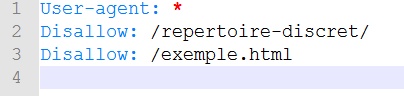

Cette ligne indique à quel robot s'applique les règles qui suivent. Une * indique que tous les robots sont concernés.

Cette ligne précise les dossiers ou les pages Web qu'il ne faut pas indexer. Un / indique que rien ne doit être indexé.

Permet d'indexer un répertoire ou une page Web dont l'indexation du répertoire parent est bloquée.